一文读懂Meta Connect 2024:Llama 3.2来了,AR眼镜Orian亮相

一文读懂Meta Connect 2024:Llama 3.2来了,AR眼镜Orian亮相Meta Connect 2024推出Quest 3S、Llama 3.2与AR眼镜Orion。

Meta Connect 2024推出Quest 3S、Llama 3.2与AR眼镜Orion。

把Llama 3蒸馏到Mamba,推理速度最高可提升1.6倍!

如果可以使用世界上所有的算力来训练AI模型,会怎么样?近日,凭借发布了开源的Hermes 3(基于Llama 3.1)而引起广泛关注的Nous Research,再次宣布了一项重大突破——DisTrO(分布式互联网训练)。

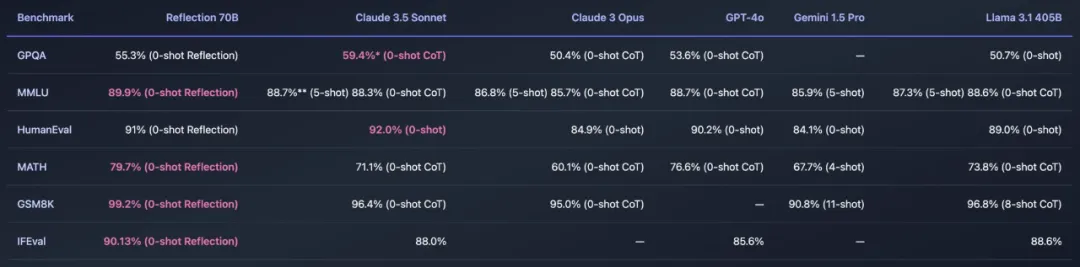

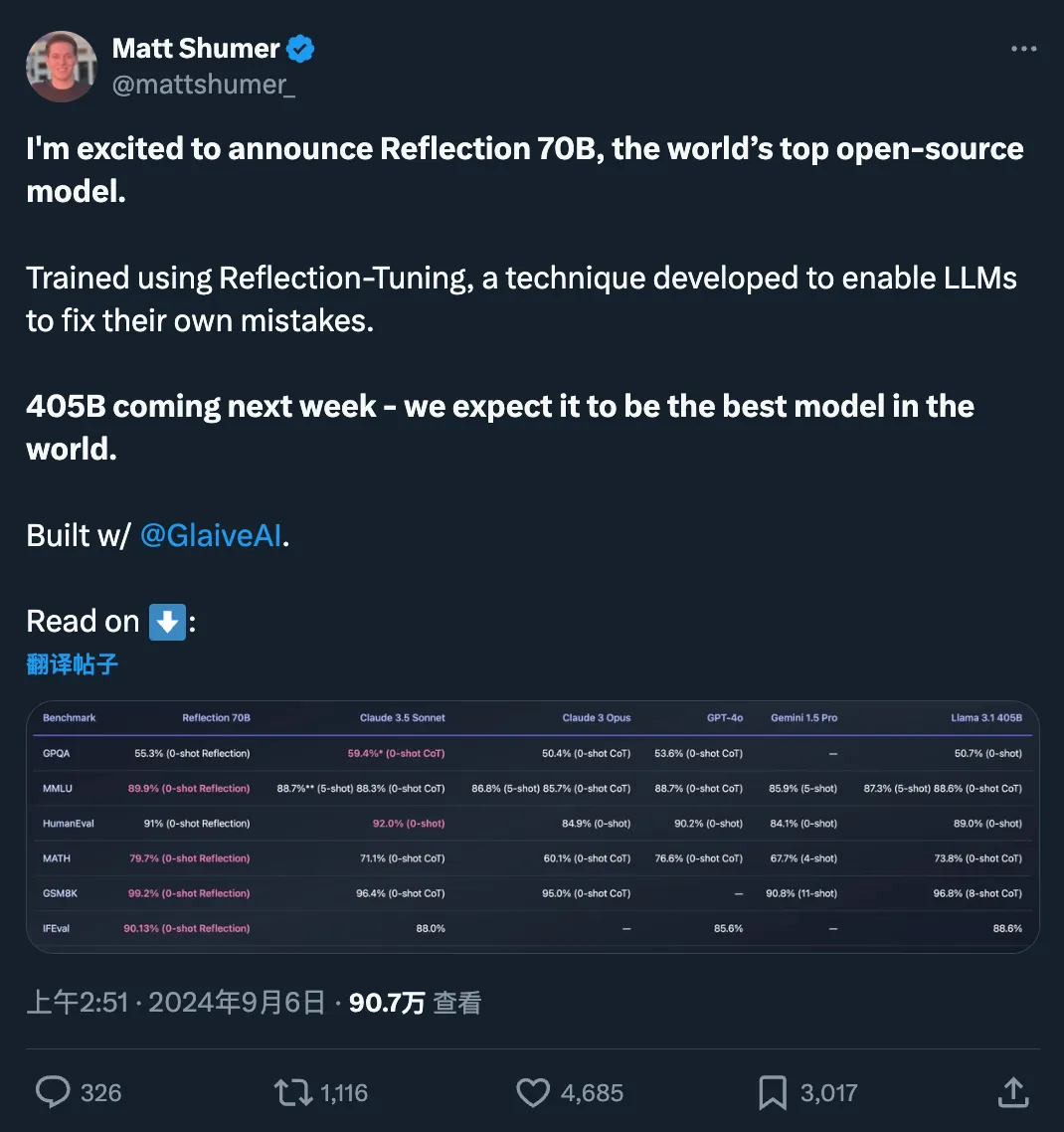

最近,开源大模型社区再次「热闹」了起来,主角是 AI 写作初创公司 HyperWrite 开发的新模型 Reflection 70B。

快速更迭的开源大模型领域,又出现了新王:Reflection 70B。 横扫 MMLU、MATH、IFEval、GSM8K,在每项基准测试上都超过了 GPT-4o,还击败了 405B 的 Llama 3.1。 这个新模型 Reflection 70B,来自 AI 写作初创公司 HyperWrite。

今天一大早,Meta 便秀了一把「Llama 系列模型在开源领域取得的成绩」,包括如下:

最近,Meta的多个工程团队联合发表了一篇论文,描述了在引入基于GPU的分布式训练时,他们如何为其「量身定制」专用的数据中心网络。

Meta的开源大模型Llama 3在市场上遇冷,进一步加剧了大模型开源与闭源之争的关注热度。

随着LLM不断迭代,偏好和评估数据中大量的人工标注逐渐成为模型扩展的显著障碍之一。Meta FAIR的团队最近提出了一种使用迭代式方法「自学成才」的评估模型训练方法,让70B参数的Llama-3-Instruct模型分数超过了Llama 3.1-405B。

Meta加强推广Llama模型,谋求AI市场领导